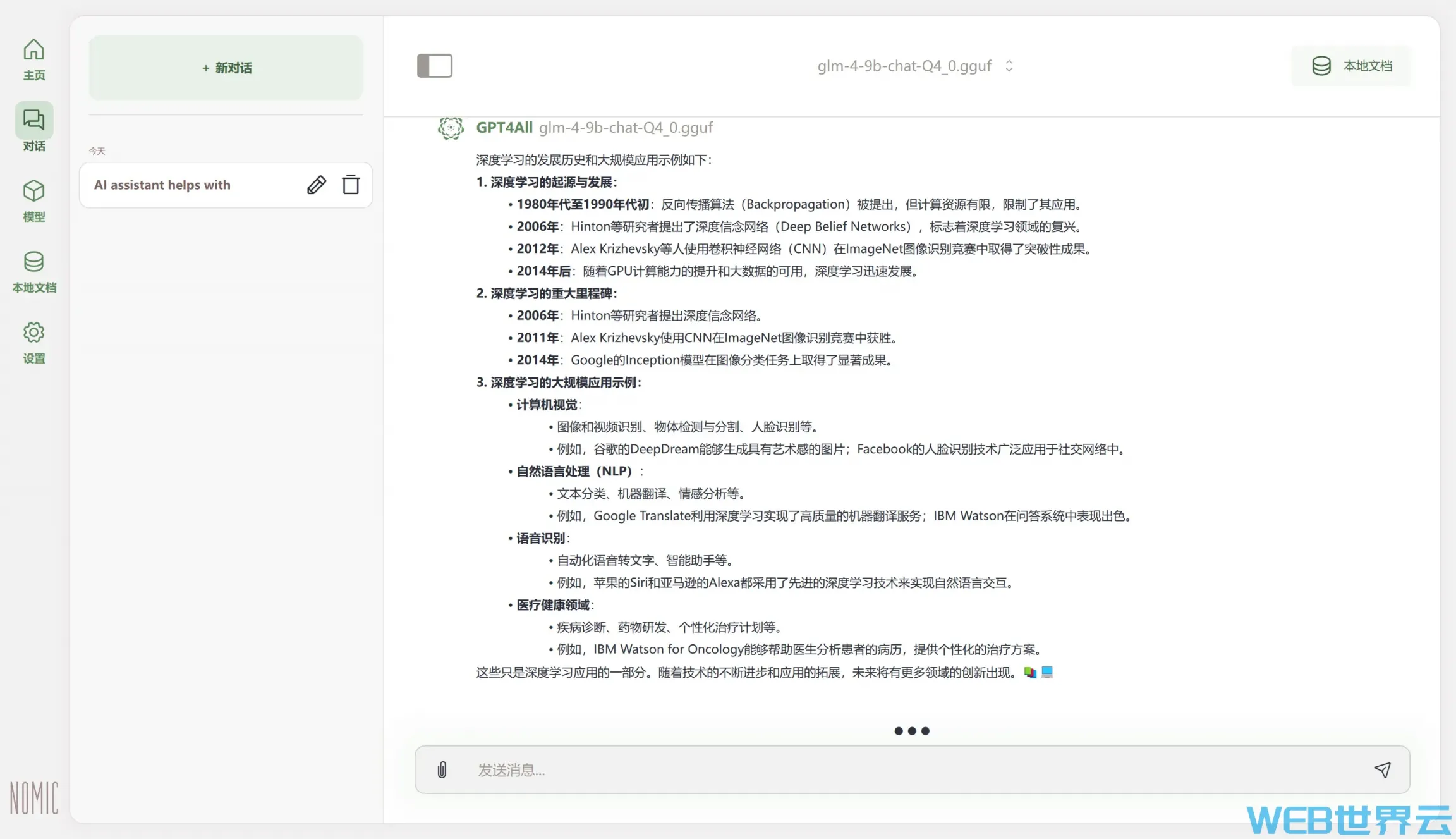

GPT4All 将 LLM 作为应用程序在您的计算机上运行,Nomic 的嵌入模型可以将本地文档和文件中的信息引入您的聊天中,它速度快、设备上且完全私密。且GPT4All在日常台式机和笔记本电脑上私下运行大型语言模型(LLMs),无需 API 调用或 GPU – 您只需下载应用程序即可开始使用。

支持哪些语言模型?

我们支持已上传到 HuggingFace 的 implementation 的模型。llama.cpp

通过访问Models – Hugging Face可以获取并下载模型到本地,并通过配置GPT4All设置中的下载目录以加载指定模型。

支持哪些嵌入模型?

我们支持SBert和Nomic Embed Text v1 & v1.5。

我需要什么软件?

您只需将 GPT4all 安装到您的 Windows、Mac 或 Linux 计算机上即可。

支持哪些 SDK 语言?

为了提高可用性,我们的 SDK 使用 Python 编写,但这些是围绕llama.cpp实现的轻量级绑定,我们为日常计算机的效率和可访问性做出了贡献。

有 API 吗?

是的,您可以使用我们兼容 OpenAI 的 API 在服务器模式下运行您的模型,您可以在设置中配置

我可以监控 GPT4All 部署吗?

是的,GPT4All 与 OpenLIT 集成,因此您可以部署 LLM,并自动监控用户交互和硬件使用情况以实现完全可观察性。

是否有命令行界面 (CLI)?

是的,我们可以将 Python 客户端作为 CLI 进行轻量级使用。我们欢迎更多的贡献!

我需要什么硬件?

GPT4All 可以在 CPU、Metal(Apple Silicon M1+)和 GPU 上运行。

系统要求是什么?

您的 CPU 需要支持 AVX 或 AVX2 指令,并且您需要足够的 RAM 才能将模型加载到内存中。

评论留言